بر اساس یک نظرسنجی در حال انجام از بیش از 100,000 پاسخ دهنده، علاقه مندان به هوش مصنوعی کار با ابزارهای منبع باز را به ابزارهای تجاری اختصاصی ترجیح می دهند.

ظهور Mistral AI’s Mixtral 8x7B، یک مدل منبع باز، تأثیر قابل توجهی در فضای هوش مصنوعی گذاشته است. سبک و قدرتمند، رمزگشایی کنید Mixtral را در بین بهترین LLM های سال 2023 معرفی کرد. Mixtral به دلیل عملکرد قابل توجه خود در تست های معیار مختلف، به ویژه Chatbot Arena، که یک رویکرد انسان محور منحصر به فرد برای ارزیابی LLM ها ارائه می دهد، توجه زیادی را به خود جلب کرده است.

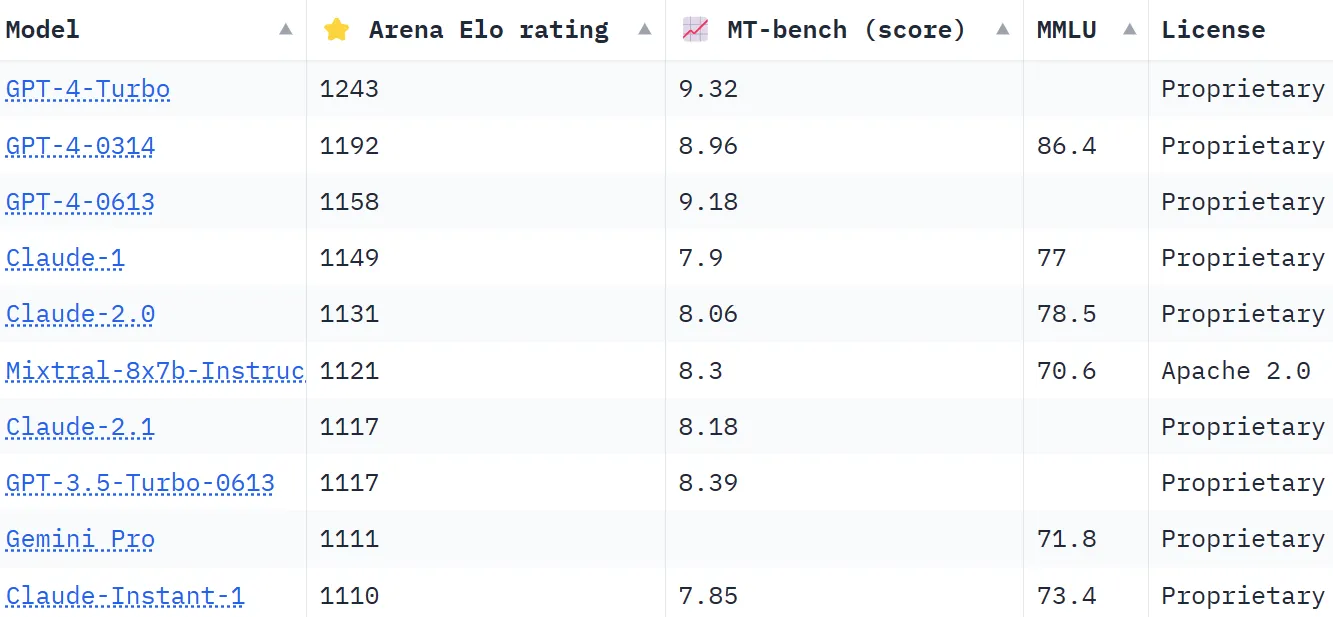

رتبهبندی Chatbot Arena، یک فهرست جمعسپاری، بیش از 130,000 رای کاربر را برای محاسبه رتبهبندی Elo برای مدلهای هوش مصنوعی به کار میگیرد. در مقایسه با روشهای دیگری که سعی میکنند نتایج را استاندارد کنند تا عینیتر باشند، این عرصه رویکرد «انسانیتر» را انتخاب میکند و از مردم میخواهد بین دو پاسخ ارائهشده توسط LLMS ناشناس کورکورانه یکی را انتخاب کنند. این پاسخ ها ممکن است با استانداردهای خاصی غیر متعارف به نظر برسند، اما می توانند به طور شهودی توسط کاربران واقعی انسان ارزیابی شوند.

Mixtral جایگاهی چشمگیر دارد و از غولهای صنعتی مانند Claude 2.1 Anthropíc، GPT-3.5 OpenAI که نسخه رایگان ChatGPT و Google's Gemini را قدرت میدهد، یک LLM چندوجهی که به عنوان قدرتمندترین ربات چت برای به چالش کشیدن سلطه GPT-4 فروخته شد، پیشی میگیرد.

یکی از تمایزهای قابل توجه Mixtral این است که تنها LLM منبع باز در Chatbot Arena 10 برتر است. این تمایز فقط یک موضوع رتبه بندی نیست. این نشان دهنده یک تغییر قابل توجه در صنعت هوش مصنوعی به سمت مدل های در دسترس تر و جامعه محور است. همانطور که توسط رمزگشایی کنیدMistral AI گفت که مدل آن "در اکثر معیارها با 2 برابر استنتاج سریعتر از LlaMA 70 6B بهتر عمل می کند و در اکثر معیارهای استاندارد با GPT 3.5 مطابقت دارد یا بهتر است." مانند MMLU، Arc-C یا GSM.

راز موفقیت Mixtral در معماری «مخلوط کارشناسان» (MoE) آن نهفته است. این تکنیک از چندین مدل متخصص مجازی استفاده می کند که هر کدام در یک موضوع یا زمینه مجزا تخصص دارند. وقتی میکسترال با مشکلی مواجه میشود، مرتبطترین کارشناسان را از مجموعه خود انتخاب میکند که منجر به خروجیهای دقیقتر و کارآمدتر میشود.

میسترال در مقاله اخیراً منتشر شده LLM توضیح داد: «در هر لایه، برای هر توکن، یک شبکه روتر دو گروه از این گروهها («متخصصان») را برای پردازش توکن و ترکیب خروجیهای آنها به صورت افزودنی انتخاب میکند. این تکنیک ضمن کنترل هزینه و تأخیر، تعداد پارامترهای یک مدل را افزایش میدهد، زیرا مدل تنها از کسری از کل مجموعه پارامترها در هر توکن استفاده میکند.

علاوه بر این، Mixtral به دلیل مهارت چند زبانه خود متمایز است. این مدل در زبان هایی مانند فرانسوی، آلمانی، اسپانیایی، ایتالیایی و انگلیسی برتری دارد و تطبیق پذیری و پتانسیل گسترده خود را به نمایش می گذارد. ماهیت منبع باز آن، تحت مجوز Apache 2.0، به توسعه دهندگان این امکان را می دهد تا آزادانه مدل را کاوش، اصلاح و ارتقا دهند و یک محیط مشارکتی و نوآورانه را تقویت کنند.

موفقیت Mixtral به وضوح فقط به مهارت فنی مربوط نمی شود. این یک پیروزی کوچک اما مهم برای جامعه AI منبع باز است. شاید در آیندهای نه چندان دور، این سوال این نباشد که کدام مدل اول بوده است، یا کدام یک پارامترها یا قابلیتهای زمینه بیشتری دارد، اما کدام یک واقعاً در بین مردم طنینانداز است.

ویرایش شده توسط رایان اوزاوا.

از اخبار ارزهای دیجیتال مطلع باشید، بهروزرسانیهای روزانه را در صندوق ورودی خود دریافت کنید.

منبع: https://decrypt.co/212236/people-rank-open-source-ai-output-better-than-commercial-plays